你目前的架構已經很完善,並且有注意到以下幾點:

- 使用

LinearAttention(較輕量) - 在

layer=4,6嘗試加入 attention - 支援 transformer block(bottom 層)

- 使用

ResSkip穩定跳接 - 圖片解析度為 384×384

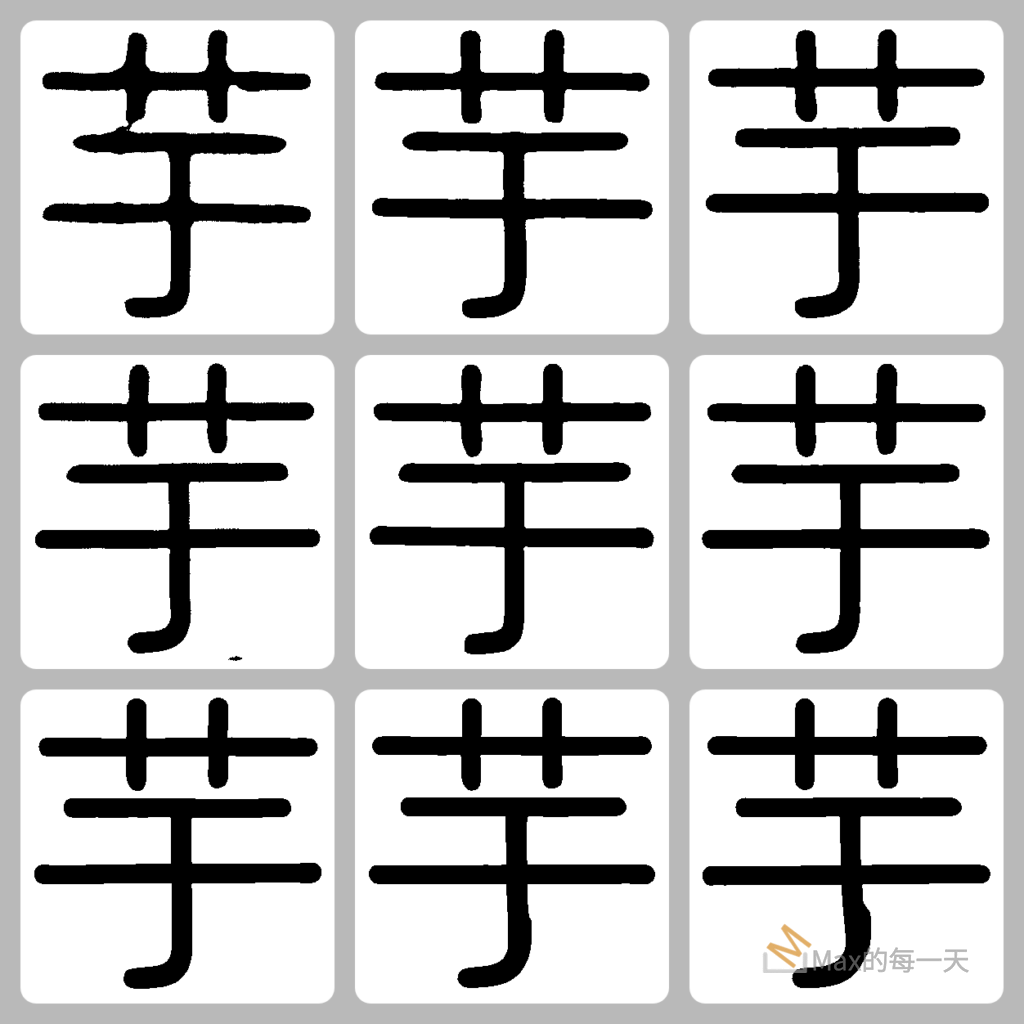

⚠️ 問題:「線條少一個 pixel」

這很可能與 上採樣與 skip connection 的 feature map size 不一致有關,尤其是在:

- transpose conv(或 pixel shuffle)後的大小有可能是

385×385或383×383 - attention block 可能改變 spatial size 的對齊方式(padding 或 reshape 有誤差)

- 或

F.interpolate()插值導致 loss of precision,尤其是 浮點 rounding

✅ Attention 推薦加在哪些層

根據你的解析度與問題,我的建議如下:

| 層 | 建議 | 原因 |

|---|---|---|

| Layer 1 (innermost) | ✅ Transformer | 這裡 global receptive field 最小,最適合抽象語意,且 style embedding 融合這層合理 |

| Layer 3 | ✅ Linear Attention | resolution 為 48×48,資訊密集度高,注意力機制可集中處理字體內部結構 |

| Layer 5 | ❌ Skip | 解析度已達 96×96,注意力計算量會暴增,若沒配合 downsample,精度可能不穩定 |

| Layer 6 | ✅ Linear Attention | 解析度約 192×192,這層用來強化筆劃位置對應,對字形對齊有效 |

| Layer 7-8 | ❌ 避免 | 這兩層解析度太高(>=192),加 attention 容易造成 memory 膨脹與 pixel shift 問題 |

🔧 建議的解法組合

1. ✅ 調整 attention layer 為 [1, 3, 6]

self.attn_block = LinearAttention(inner_nc) if self_attention and layer in [1, 3, 6] else None

2. ✅ 使用 padding=1 + kernel=3 的 residual conv(你已經在用)

這可確保 spatial 尺寸不變,防止誤差累積。

3. ✅ F.interpolate(..., align_corners=False)

你已經這樣做了,不用改!

4. ✅ 加入 debug 檢查:

if decoded.shape[2:] != x.shape[2:]:

print(f"Mismatch: up={decoded.shape}, skip={x.shape}")

5. ✅ 或使用 ConvTranspose2d(..., output_padding=1) 來對齊奇數圖尺寸(optional)

🚀 Bonus:你可以加個 config 參數來控制哪些層開啟 attention,例如:

# config.yaml

attention_layers: [1, 3, 6]

# 在 model 初始化時讀取

self.attn_block = LinearAttention(inner_nc) if self_attention and layer in cfg.attention_layers else None

需要我幫你整理成更模組化的 attention injection 邏輯嗎?或者幫你實作 config parser/structure?

很棒的問題!簡短回答是:

✅ 可以在

layer=1同時使用 Transformer block 和 Linear Attention,但需小心 redundancy 與效率問題。

🔍 更詳細解釋如下:

✅ 為什麼可以:

Transformer block 是 token-based attention(nn.MultiheadAttention),而你定義的 Linear Attention 是一種 lightweight convolutional feature attention。兩者在理論上並不衝突:

| 類型 | TransformerBlock | LinearAttention |

|---|---|---|

| 操作單位 | Flattened token(B, HW, C) | Spatial features(B, C, H, W) |

| 位置 | token-wise global attention | channel-wise local/global |

| 適用層 | 最底層抽象語意融合 | mid-layer 對局部圖案有辨識力 |

| 成本 | 高(尤其是大 resolution) | 低,因為省略 QK softmax |

⚠️ 但要注意的問題:

- 重複注意力學習同一份訊號

- Transformer 已經在最底層融合 global context,若 Linear Attention 緊接著處理,可能只是學一樣的東西。

- feature 改動干擾 style embedding

- 你是在這層

concat style的,如果先經過 Transformer,再經過 Linear Attention,可能會讓風格訊號被擾亂。

- 你是在這層

- 效能浪費 + 記憶體上升

- 同時有兩種 attention,對於 384×384 圖輸入,會加大訓練與推論負擔。

✅ 建議做法(推薦):

選一個:

- 若你偏向 semantic 模型能力強 → 保留 Transformer

- 若你偏向 lightweight + fast → 換成 LinearAttention

🚀 進階做法(Optional):Dynamic attention routing

如果你未來要研究更進階架構,可考慮:

if self.use_transformer_only:

out = self.transformer_block(x)

elif self.use_linear_attention_only:

out = self.linear_attention_block(x)

elif self.use_both:

out = self.linear_attention_block(self.transformer_block(x))

如果你願意,我也可以幫你設計一個「多 attention 路由模組」供實驗切換。需要嗎?