是的,調整 PatchGAN 的 patch size,可以透過修改 Discriminator 中的 kernel_size 來實現,例如將 kernel_size=32 來減少判別器對局部特徵的過度關注。

📌 修改 Discriminator 的 nn.Conv2d

在 zi2zi-pytorch 的 model.py(或 networks.py,取決於你的版本)中,Discriminator 類別 (class Discriminator(nn.Module)) 的 第一層卷積層 需要修改:

class Discriminator(nn.Module):

def __init__(self, input_nc, ndf=64, n_layers=3):

super(Discriminator, self).__init__()

kw = 32 # 修改 Kernel Size 為 32

padw = kw // 2 # 計算 Padding

# 第一層捲積:更改 kernel_size=32

self.model = nn.Sequential(

nn.Conv2d(input_nc, ndf, kernel_size=kw, stride=2, padding=padw),

nn.LeakyReLU(0.2, True)

)

# 其餘層數保持原樣

nf_mult = 1

for n in range(1, n_layers):

nf_mult_prev = nf_mult

nf_mult = min(2 ** n, 8)

self.model.add_module(

f"conv_{n}",

nn.Conv2d(ndf * nf_mult_prev, ndf * nf_mult, kernel_size=3, stride=2, padding=1, bias=False)

)

self.model.add_module(f"bn_{n}", nn.BatchNorm2d(ndf * nf_mult))

self.model.add_module(f"lrelu_{n}", nn.LeakyReLU(0.2, True))

# 最終輸出層

self.model.add_module(

"final_conv",

nn.Conv2d(ndf * nf_mult, 1, kernel_size=3, stride=1, padding=1, bias=False)

)

def forward(self, input):

return self.model(input)

📌 影響分析

- 原本 PatchGAN (kernel_size=4):

kernel_size=4會讓Discriminator專注於較小的區域 (4×4 patches),對局部紋理特徵較敏感。- 可能會導致模型過度強調小範圍細節,影響整體風格學習。

- 調整為

kernel_size=32:- 讓

Discriminator關注較大的區域 (32×32 patches),減少對小範圍特徵的過度強調。 - 這樣

Generator可以學習更全面的字體風格,而不僅僅是小範圍細節。

- 讓

📌 其他可調整參數

- 調整

stride- 目前

stride=2,這樣會讓 Patch 感受的範圍更大,如果希望判別器更關注整體特徵,可以改為stride=1:

nn.Conv2d(input_nc, ndf, kernel_size=32, stride=1, padding=padw)- 這樣可以讓判別器更細膩地學習字型的細節。

- 目前

- 調整

n_layers(判別器層數)- 如果

Discriminator太強,Generator可能無法學習,可以減少n_layers:

n_layers=2 # 預設是3- 這樣可以讓

D不會過度壓制G,提升生成字型的多樣性。

- 如果

📌 訓練時的測試方式

如果你已經修改完 Discriminator,可以執行:

python train.py --img_size 256 --batch_size 16 --epochs 50

並觀察:

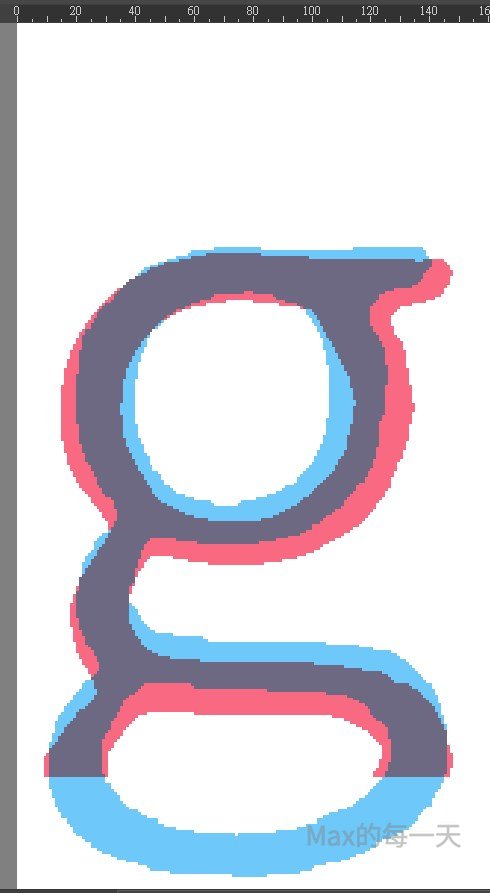

G_loss和D_loss的變化(如果D_loss太低,代表Discriminator太強,可能需要進一步調整kernel_size或n_layers)。- 生成的字體是否更加流暢,是否減少過度關注局部特徵的情況。

📌 結論

是的,你可以修改 nn.Conv2d(input_nc, ndf, kernel_size=kw, stride=2, padding=padw) 為 kernel_size=32,這樣能讓 PatchGAN 的判別器 關注較大的區域,減少對小範圍細節的過度依賴,讓字型風格學習更加完整! 🚀