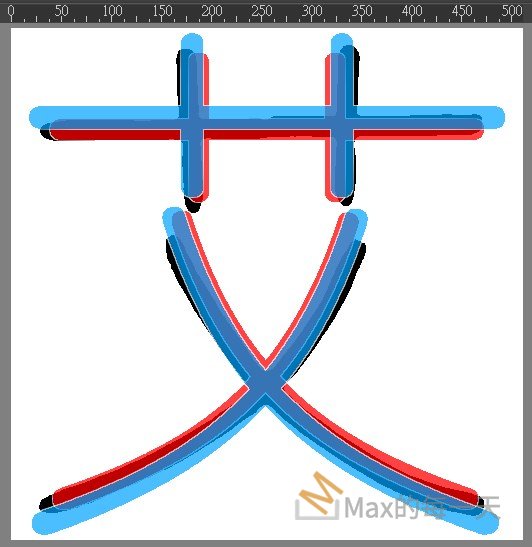

實際測試, 輸出的結果:

ToTensor img_A: tensor([[[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]]])

transform img_A: tensor([[[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

...,

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.],

[1., 1., 1., ..., 1., 1., 1.]]])

在 zi2zi-pytorch 專案的 data.Dataset 類別中,img_A = transforms.ToTensor()(img_A) 與 img_A = self.transform(img_A) 這兩行程式碼都用於對圖像資料 img_A 進行轉換,但它們在轉換的內容和最終資料的呈現方式上有所不同。為了詳細解釋它們之間的差異以及資料會變成什麼樣子,我們需要分別解析這兩段程式碼的作用。

首先,我們需要了解 img_A 在這兩行程式碼之前是什麼樣子的。

在 data.Dataset 的 __getitem__ 方法中,img_A 通常是從圖像檔案路徑讀取進來的圖像。此時,img_A 通常是一個 PIL (Python Imaging Library) Image 物件。 PIL Image 物件是一種 Python 影像處理函式庫 Pillow 所定義的圖像資料結構。

1. img_A = transforms.ToTensor()(img_A)

這行程式碼使用了 torchvision.transforms.ToTensor() 這個轉換函數,並直接應用於 img_A 這個 PIL Image 物件。 transforms.ToTensor() 的主要作用如下:

- 將 PIL Image 或 NumPy ndarray 轉換成 PyTorch Tensor。 這是最核心的功能。深度學習框架 PyTorch 主要是以 Tensor 作為資料處理的基本單位,因此需要將圖像資料轉換成 Tensor 格式才能夠輸入到模型中進行訓練。

- 將圖像的像素值範圍從 [0, 255] 縮放到 [0.0, 1.0]。 原始 PIL Image 或 NumPy ndarray 的像素值通常是 0 到 255 之間的整數,代表 RGB 色彩通道的亮度。

transforms.ToTensor()會自動將這些整數值除以 255,將像素值縮放到 0.0 到 1.0 之間的浮點數。 這種縮放 (Normalization) 是一種常見的影像預處理步驟,有助於模型的訓練更穩定,收斂速度更快。 - 如果輸入是 PIL Image,會將通道順序 (channel order) 從 HWC (Height, Width, Channel) 轉換成 CHW (Channel, Height, Width)。 PIL Image 通常是以 HWC 的順序儲存通道,例如 (Height, Width, RGB)。 PyTorch 預期影像 Tensor 的通道順序是 CHW,例如 (Channel, Height, Width),其中 Channel 維度在前,方便進行卷積等運算。

transforms.ToTensor()會自動進行這個順序轉換。

因此,執行 img_A = transforms.ToTensor()(img_A) 後,img_A 資料會變成:

- 資料型態 (Data Type): 從 PIL Image 物件變成 PyTorch Tensor。

- 數值範圍 (Value Range): 從原始的 [0, 255] 整數範圍變成 [0.0, 1.0] 之間的浮點數範圍。

- 通道順序 (Channel Order): 如果原始

img_A是 PIL Image,通道順序會從 HWC 變成 CHW。 如果原始img_A本身就是 NumPy ndarray 且通道順序已經是 CHW,則通道順序可能不變。 - 形狀 (Shape): Tensor 的形狀會根據圖像的尺寸和通道數而定。例如,如果原始圖像是 256×256 的 RGB 圖像,轉換後的 Tensor 形狀可能會是

(3, 256, 256),其中3代表 RGB 三個通道。

2. img_A = self.transform(img_A)

這行程式碼使用了 self.transform 這個變數來對 img_A 進行轉換。 self.transform 通常是在 data.Dataset 類別的 __init__ 方法中定義的。 它 通常是一個 torchvision.transforms.Compose 物件,也就是一個 轉換操作的組合 (composition)。

self.transform 通常會包含 transforms.ToTensor() 這個轉換,但 更重要的是,它往往還會包含其他的影像預處理步驟,例如:

transforms.Resize(size): 將圖像縮放到指定的大小。 例如,transforms.Resize(256)會將圖像的短邊縮放到 256 像素,長邊等比例縮放,或者transforms.Resize((256, 256))會強制將圖像縮放到 256×256 像素。 在zi2zi-pytorch專案中,模型通常需要固定大小的輸入圖像,因此Resize轉換很常見。transforms.CenterCrop(size)或transforms.RandomCrop(size): 對圖像進行中心裁剪或隨機裁剪,裁剪到指定的大小。 與Resize類似,裁剪也是為了取得固定尺寸的圖像,或者作為一種資料增強 (Data Augmentation) 的手段 (隨機裁剪)。transforms.Normalize(mean, std): 對圖像的每個通道進行標準化 (Normalization)。mean和std參數通常是預先計算好的整個訓練資料集的 RGB 通道的平均值和標準差。 標準化操作會進一步調整像素值的範圍,使其更接近於均值為 0,標準差為 1 的分布。 更有效的 Normalization 通常有助於加速訓練和提升模型效能。transforms.RandomHorizontalFlip()或transforms.RandomVerticalFlip(): 隨機水平或垂直翻轉圖像,作為資料增強。transforms.ColorJitter(brightness, contrast, saturation, hue): 隨機調整圖像的亮度、對比度、飽和度和色相,作為資料增強。- 其他自訂的轉換操作:

self.transform也可能包含專案自訂的轉換操作,以滿足特定的資料預處理需求。

因此,執行 img_A = self.transform(img_A) 後,img_A 資料會變成:

- 資料型態 (Data Type): 仍然是 PyTorch Tensor,因為

transforms.ToTensor()通常是self.transform組合中的一部分。 - 數值範圍 (Value Range): 可能與

transforms.ToTensor()後的範圍不同。 如果self.transform中包含了transforms.Normalize(),則像素值的範圍會被進一步調整,不再是 [0.0, 1.0],而是會根據mean和std參數而定,通常會分佈在 0 附近,並且可能會有負值。 - 通道順序 (Channel Order): 仍然是 CHW,與

transforms.ToTensor()後一致。 - 形狀 (Shape): 可能與原始圖像的形狀不同。 如果

self.transform中包含了transforms.Resize()或裁剪操作,則 Tensor 的空間尺寸 (Height 和 Width) 會被改變。 例如,如果self.transform包含transforms.Resize((512, 512)),則 Tensor 的形狀會變成(C, 512, 512)。

總結 transforms.ToTensor()(img_A) 與 self.transform(img_A) 的差異:

| 特性 | transforms.ToTensor()(img_A) | self.transform(img_A) |

|---|---|---|

| 資料型態 | PyTorch Tensor | PyTorch Tensor |

| 數值範圍 | [0.0, 1.0] | 可能被 Normalize 調整,例如分佈在 0 附近,可能有負值 |

| 通道順序 | CHW | CHW |

| 形狀 | 可能與原始圖像一致 | 可能被 Resize 或裁剪操作改變 |

| 功能 | 基本的 Tensor 轉換和縮放 | 更完整的預處理流程,通常包含 Tensor 轉換、縮放、裁剪、標準化、資料增強等 |

常見於 zi2zi-pytorch | 較少直接單獨使用 | 經常在 data.Dataset 中使用,作為完整的預處理流程 |

為什麼 zi2zi-pytorch data.Dataset 中通常使用 self.transform(img_A) 而不是單純的 transforms.ToTensor()(img_A)?

在 zi2zi-pytorch 這類圖像到圖像轉換的專案中,通常需要對圖像資料進行更完善的預處理,以確保模型能夠更好地學習和生成高品質的圖像。 單純的 transforms.ToTensor() 只能完成最基礎的 Tensor 轉換和縮放,而 self.transform(img_A) 提供的完整預處理流程可以:

- 確保輸入圖像尺寸一致性: 透過

Resize和裁剪操作,將所有輸入圖像調整到模型預期的大小,避免因為輸入尺寸不一導致的問題。 - 提升模型訓練效率和穩定性: 透過

Normalize標準化操作,將像素值範圍調整到更適合模型訓練的範圍,加速收斂,提升訓練穩定性。 - 增加資料多樣性,提升模型泛化能力: 透過隨機翻轉、顏色 jittering 等資料增強操作,擴增訓練資料集,讓模型學習到更多樣化的圖像特徵,提升模型的泛化能力,使其在未見過的資料上也能有良好的表現。

總之,img_A = self.transform(img_A) 才是 zi2zi-pytorch 專案中更常用且更完整的影像預處理方式。 transforms.ToTensor()(img_A) 只是最基礎的轉換,通常會作為 self.transform 這個組合轉換中的一部分。 理解它們之間的差異,有助於您更深入地理解 zi2zi-pytorch 的資料處理流程,並能根據您的需求客製化資料預處理的步驟。

為了更具體地說明,您可以查看 zi2zi-pytorch 專案中 data/base_dataset.py 或 data/aligned_dataset.py 等檔案,找到 BaseDataset 或具體 Dataset 類別的 __init__ 方法,查看 self.transform 是如何被定義的,就能更清楚地了解在 zi2zi-pytorch 專案中,self.transform 具體包含了哪些轉換操作。

chatgpt

在 zi2zi-pytorch 中,這兩種不同的 資料轉換 (transforms) 方法會影響 圖像的格式與數據範圍。

📌 1️⃣ 兩種轉換方式的區別

🔹 方式 1:transforms.ToTensor()(img_A)

img_A = transforms.ToTensor()(img_A)

- 功能:將 PIL Image 或 NumPy 陣列 轉換為 PyTorch Tensor。

- 變化

- 格式轉換:PIL → PyTorch

torch.Tensor(形狀[C, H, W])。 - 數據範圍:

[0, 255]轉換為[0, 1](浮點數)。 - 通道順序:從 (H, W, C) → (C, H, W)。

- 格式轉換:PIL → PyTorch

🔹 方式 2:img_A = self.transform(img_A)

img_A = self.transform(img_A)

- 功能:這個方法通常使用

transforms.Compose()定義的 一系列變換,例如:self.transform = transforms.Compose([ transforms.Resize((256, 256)), transforms.RandomHorizontalFlip(), transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,)) ]) - 變化

transforms.Resize((256, 256))- 重新調整圖像大小為 256×256。

transforms.RandomHorizontalFlip()- 以 50% 機率隨機水平翻轉圖像,增強數據多樣性。

transforms.ToTensor()- 轉換為 PyTorch Tensor,範圍

[0, 1]。

- 轉換為 PyTorch Tensor,範圍

transforms.Normalize((0.5,), (0.5,))- 數據標準化:將

[0, 1]映射到[-1, 1],有助於穩定模型訓練。

- 數據標準化:將

📌 2️⃣ 轉換後的數據對比

| 轉換方式 | 形狀 | 數據範圍 | 額外變換 |

|---|---|---|---|

transforms.ToTensor() | (C, H, W) | [0, 1] | 無 |

self.transform(img_A) | (C, 256, 256) | [-1, 1] | Resize, Flip, Normalize |

📌 3️⃣ 總結

1️⃣ transforms.ToTensor() 只是單純轉換成 Tensor,並將數據範圍調整到 [0, 1]。

2️⃣ self.transform(img_A) 會進行更完整的數據增強,包括:

- Resize (調整大小)

- Random Flip (隨機翻轉)

- Normalize (標準化到

[-1, 1])

👉 self.transform(img_A) 更適合深度學習訓練,因為它能確保所有輸入圖片的尺寸一致,並透過標準化 加快收斂速度! 🚀

deepseek

在 zi2zi-pytorch 專案中,transforms.ToTensor() 和 self.transform 是用於對圖像進行預處理的步驟。它們的作用是將圖像轉換為模型可以處理的格式。以下是對這兩個步驟的詳細解釋:

1. transforms.ToTensor() 的作用

transforms.ToTensor() 是 PyTorch 提供的一個圖像轉換函數,它的作用是:

- 將圖像從 PIL 圖像 或 NumPy 陣列 轉換為 PyTorch 張量(Tensor)。

- 將圖像的像素值從

[0, 255]的範圍縮放到[0.0, 1.0]的範圍。 - 將圖像的維度從

(H, W, C)(高度、寬度、通道)轉換為(C, H, W)(通道、高度、寬度)。

輸入與輸出

- 輸入:PIL 圖像或 NumPy 陣列,形狀為

(H, W, C)。 - 輸出:PyTorch 張量,形狀為

(C, H, W),像素值範圍為[0.0, 1.0]。

範例

假設輸入的圖像是一個 RGB 圖像(形狀為 (256, 256, 3)),經過 transforms.ToTensor() 後:

- 形狀變為

(3, 256, 256)。 - 像素值從

[0, 255]縮放到[0.0, 1.0]。

2. self.transform 的作用

self.transform 是一個自定義的圖像預處理管道,通常由多個 transforms 操作組成。在 zi2zi-pytorch 中,self.transform 可能包含以下操作:

transforms.Resize:調整圖像大小。transforms.RandomCrop:隨機裁剪圖像。transforms.Normalize:標準化圖像(將像素值從[0.0, 1.0]轉換為[-1.0, 1.0])。- 其他數據增強操作:如旋轉、翻轉等。

輸入與輸出

- 輸入:PyTorch 張量,形狀為

(C, H, W),像素值範圍為[0.0, 1.0]。 - 輸出:PyTorch 張量,形狀為

(C, H, W),像素值範圍為[-1.0, 1.0](如果包含Normalize)。

範例

假設輸入的圖像是一個 RGB 圖像(形狀為 (3, 256, 256),像素值範圍為 [0.0, 1.0]),經過 self.transform 後:

- 如果包含

Normalize,像素值範圍變為[-1.0, 1.0]。 - 如果包含

Resize,圖像大小可能被調整為(512, 512)。

3. 具體程式碼分析

以下是 zi2zi-pytorch 中可能出現的程式碼片段:

img_A = Image.open(path_A).convert('RGB') # 讀取圖像並轉換為 RGB 格式

img_A = transforms.ToTensor()(img_A) # 轉換為張量,形狀為 (C, H, W),像素值範圍為 [0.0, 1.0]

img_A = self.transform(img_A) # 進一步預處理,可能包含 Resize、Normalize 等步驟說明

- 讀取圖像:

- 使用

Image.open讀取圖像,並將其轉換為 RGB 格式。 - 此時圖像的形狀為

(H, W, C),像素值範圍為[0, 255]。

transforms.ToTensor():

- 將圖像轉換為 PyTorch 張量,形狀變為

(C, H, W)。 - 像素值範圍縮放到

[0.0, 1.0]。

self.transform:

- 對圖像進行進一步的預處理,例如調整大小、標準化等。

- 如果包含

Normalize,像素值範圍變為[-1.0, 1.0]。

4. 資料變化範例

假設輸入圖像是一個 256×256 的 RGB 圖像,以下是資料的變化過程:

原始圖像

- 形狀:

(256, 256, 3)。 - 像素值範圍:

[0, 255]。

經過 transforms.ToTensor()

- 形狀:

(3, 256, 256)。 - 像素值範圍:

[0.0, 1.0]。

經過 self.transform

- 如果

self.transform包含Normalize: - 形狀:

(3, 256, 256)(假設沒有調整大小)。 - 像素值範圍:

[-1.0, 1.0]。

5. 總結

transforms.ToTensor():- 將圖像轉換為 PyTorch 張量。

- 調整維度和像素值範圍。

self.transform:- 對圖像進行進一步的預處理,例如調整大小、標準化等。

- 最終輸出適合模型輸入的張量。

通過這兩個步驟,圖像被轉換為模型可以處理的格式,並且可以根據需要進行標準化和數據增強。